Introducción:

En la sociedad en la que vivimos la tecnología resulta

imprescindible y avanza cada vez más rápido y de una forma más sorprendente día

a día, haciendo imposible visualizar el límite al que llegaremos. Internet se

ha convertido en una herramienta necesaria sin la cual todo cambiaría por

completo, pero todo este desarrollo de Internet no podría continuar sin un desarrollo de todo lo que le rodea, ya sean móviles, sistemas de

telecomunicaciones… y los ordenadores. El ordenador es el elemento fundamental que sustenta los sistemas de información actuales, y constituye el cimiento de los sistemas de información. Casi todos tenemos un ordenador como mínimo, pero para poder llegar hasta la actualidad el ordenador ha cambiado drásticamente, y lo que cambiará en un futuro.

La característica principal que la distingue de otros dispositivos similares es que se trata de una máquina de propósito general, es decir, puede realizar tareas muy diversas gracias a las posibilidades que ofrecen los lenguajes de programación y el hardware.

Historia del ordenador:

Antes de llegar al ordenador actual las cosas eran bastante diferentes

Los ordenadores analógicos comenzaron a construirse a

principios del siglo XX. Los primeros modelos realizaban los cálculos mediante

ejes y engranajes giratorios. Con estas máquinas se evaluaban las

aproximaciones numéricas de ecuaciones demasiado difíciles como para poder ser

resueltas mediante otros métodos. Durante las dos guerras mundiales se

utilizaron sistemas informáticos analógicos, primero mecánicos y más tarde eléctricos,

para predecir la trayectoria de los torpedos en los submarinos y para el manejo

a distancia de las bombas en la aviación.

Durante la II Guerra Mundial (1939-1945), un

equipo de científicos y matemáticos que trabajaban en Bletchley Park, al norte

de Londres, crearon lo que se consideró el primer ordenador digital totalmente

electrónico: el Colossus. La máquina Colossus fue el secreto

mejor guardado por los ingleses durante la Segunda Guerra Mundial. Hacia

diciembre de 1943 este “ordenador”, que incorporaba 1.500 válvulas

o tubos de vacío, era ya operativo. Fue utilizado por el equipo dirigido por Alan

Turing para descodificar los mensajes de radio cifrados de los alemanes.

En 1939 y con independencia de este proyecto, John

Atanasoff y Clifford Berry ya habían construido un prototipo de máquina

electrónica en el Iowa State College (EEUU). Este prototipo y las

investigaciones posteriores se realizaron en el anonimato, y más tarde quedaron

eclipsadas por el desarrollo del Calculador e integrador numérico digital

electrónico (ENIAC) en 1945. El ENIAC (acrónimo de Electronic Numerical

Integrator and Computer) según mostró la evidencia se basaba en gran medida en

el “ordenador” Atanasoff-Berry.

El ENIAC contenía 18.000 válvulas de vacío y tenía una

velocidad de varios cientos de multiplicaciones por minuto, pero su programa

estaba conectado al procesador y debía ser modificado manualmente. Se construyó

un sucesor del ENIAC con un almacenamiento de programa que estaba basado en los

conceptos del matemático húngaro-estadounidense John von Neumann. Las

instrucciones se almacenaban dentro de una llamada memoria, lo que liberaba al

ordenador de las limitaciones de velocidad del lector de cinta de papel durante

la ejecución y permitía resolver problemas sin necesidad de volver a conectarse

al ordenador.

A finales de la década de 1960 apareció el circuito

integrado (CI), que posibilitó la fabricación de varios transistores en un

único sustrato de silicio en el que los cables de interconexión iban soldados.

El circuito integrado permitió una posterior reducción del precio, el tamaño y

los porcentajes de error. El microprocesador se convirtió en una

realidad a mediados de la década de 1970, con la introducción del circuito de

integración a gran escala (LSI, acrónimo de Large Scale Integrated) y, más

tarde, con el circuito de integración a mayor escala (VLSI, acrónimo de Very

Large Scale Integrated), con varios miles de transistores interconectados

soldados sobre un único sustrato de silicio.

Los ordenadores modernos son electrónicos y digitales. La maquinaria real, cables, transistores y circuitos, se llama hardware; las instrucciones y los datos se llaman software. La interacción entre ambos hace

operativa la maquinaria. En la actualidad los ordenadores (personales) constan

de los siguientes elementos de hardware (ver enlace para fotos):

- Monitor: Es un dispositivo de salida (interfaz), la pantalla de visualización, que muestra datos o información al usuario. Se trata de un dispositivo de salida (Output device).

- Placa base: También conocida como placa o tarjeta madre es una tarjeta de circuito impreso a la que se conectan los componentes que constituyen la computadora. Es una parte fundamental a la hora de armar un PC de escritorio o portátil. Tiene instalados una serie de circuitos integrados, entre los que se encuentra el circuito integrado auxiliar, que sirve como centro de conexión entre el microprocesador (CPU), la memoria de acceso aleatorio (RAM), las ranuras de expansión y otros dispositivos. Va instalada dentro de una caja o gabinete que por lo general está hecha de chapa y tienen un panel para conectar dispositivos externos (como el ratón y el teclado) y muchos conectores internos y zócalos para instalar componentes dentro de la caja. La placa base, además, incluye un firmware llamado BIOS que le permite realizar las funcionalidades básicas (pruebas de dispositivos, vídeo y manejo del teclado...)

- Unidad central de procesamiento (CPU): El procesador es el componente principal del ordenador (su cerebro) y otros dispositivos programables, que interpreta las instrucciones contenidas en los programas y procesa los datos. La CPU proporciona la característica fundamental del ordenador digital (la programabilidad) y es uno de los componentes necesarios encontrado en los ordenadores de cualquier tiempo, junto con la memoria principal y los dispositivos de entrada/salida.

Se conoce como microprocesador el CPU que es manufacturado con circuitos integrados. Hoy en día el término "CPU" es aplicado usualmente a todos los microprocesadores. Tanto la miniaturización como la estandarización de las CPU han aumentado la presencia de estos dispositivos digitales en la vida moderna muchi más allá de las aplicaciones limitadas de las máquinas de computación. Los microprocesadores modernos aparecen en todo, desde automóviles, televisores, neveras, calculadoras y aviones hasta teléfonos móviles o juguetes, entre otros. En la actualidad muchas personas llaman CPU al a la torre del ordenador, confundiendo de esta manea a los principiantes en el mundo de la computación.

- Monitor: Es un dispositivo de salida (interfaz), la pantalla de visualización, que muestra datos o información al usuario. Se trata de un dispositivo de salida (Output device).

- Placa base: También conocida como placa o tarjeta madre es una tarjeta de circuito impreso a la que se conectan los componentes que constituyen la computadora. Es una parte fundamental a la hora de armar un PC de escritorio o portátil. Tiene instalados una serie de circuitos integrados, entre los que se encuentra el circuito integrado auxiliar, que sirve como centro de conexión entre el microprocesador (CPU), la memoria de acceso aleatorio (RAM), las ranuras de expansión y otros dispositivos. Va instalada dentro de una caja o gabinete que por lo general está hecha de chapa y tienen un panel para conectar dispositivos externos (como el ratón y el teclado) y muchos conectores internos y zócalos para instalar componentes dentro de la caja. La placa base, además, incluye un firmware llamado BIOS que le permite realizar las funcionalidades básicas (pruebas de dispositivos, vídeo y manejo del teclado...)

- Unidad central de procesamiento (CPU): El procesador es el componente principal del ordenador (su cerebro) y otros dispositivos programables, que interpreta las instrucciones contenidas en los programas y procesa los datos. La CPU proporciona la característica fundamental del ordenador digital (la programabilidad) y es uno de los componentes necesarios encontrado en los ordenadores de cualquier tiempo, junto con la memoria principal y los dispositivos de entrada/salida.

Se conoce como microprocesador el CPU que es manufacturado con circuitos integrados. Hoy en día el término "CPU" es aplicado usualmente a todos los microprocesadores. Tanto la miniaturización como la estandarización de las CPU han aumentado la presencia de estos dispositivos digitales en la vida moderna muchi más allá de las aplicaciones limitadas de las máquinas de computación. Los microprocesadores modernos aparecen en todo, desde automóviles, televisores, neveras, calculadoras y aviones hasta teléfonos móviles o juguetes, entre otros. En la actualidad muchas personas llaman CPU al a la torre del ordenador, confundiendo de esta manea a los principiantes en el mundo de la computación.

- Puertos ATA: El puerto ATA (Advanced Technology

Attachment) controla los dispositivos de almacenamiento masivo de datos, como los discos duros, añadiendo además dispositivos de lectura óptica como las unidades CD-ROM.

- Memoria de acceso aleatorio (RAM): Se utiliza como memoria de trabajo para el sistema operativo, los programas y la mayoría del software. Es allí donde se cargan todas las instrucciones que ejecutan el procesador y otras unidades de cómputo. Se denominan "de acceso aleatorio" porque se puede leer o escribir en una posición de memoria con un tiempo de espera igual para cualquier posición, no siendo necesario seguir un orden para acceder a la información de la manera más rápida posible.

- Memoria de acceso aleatorio (RAM): Se utiliza como memoria de trabajo para el sistema operativo, los programas y la mayoría del software. Es allí donde se cargan todas las instrucciones que ejecutan el procesador y otras unidades de cómputo. Se denominan "de acceso aleatorio" porque se puede leer o escribir en una posición de memoria con un tiempo de espera igual para cualquier posición, no siendo necesario seguir un orden para acceder a la información de la manera más rápida posible.

- Tarjeta/Placa de expansión: Son dispositivos con diversos circuitos integrados y controlados que, insertadas en sus correspondientes ranuras de expansión, sirven para expandir las capacidades de un ordenador. Las tarjetas de expansión más comunes sirven para añadir memoria, controladoras de unidad de disco, controladoras de vídeo, puertos serie o paralelo y dispositivos de módem internos.

-Fuente de alimentación: Es un dispositivo que convierte la corriente alterna en una o varias variantes continuas, que alimentan los distintos circuitos del aparato electrónico al que se conecta (en este caso el ordenador).

-Unidad de almacenamiento óptico: Es aquel dispositivo que es capaz de guardar o leer datos por medio de un rayo láser en su superficie plástica, ya que se almacenan por medio de ranuras microscópicas. La información queda grabada en la superficie de manera física, por lo que solo el calor y las ralladuras pueden producir la pérdida de datos. Es inmune a los campos magnéticos y la humedad.

- Disco duro: Es un dispositivo de almacenamiento de datos no volátil (no necesita energía para perdurar) que emplea un sistema de grabación magnética para almacenar datos digitales. Se compone de uno o más platos o discos rígidos, unidos por un mismo eje que gira a gran velocidad dentro de una caja metálica sellada. Sobre cada plato, y en cada una de sus caras, se sitúa un cabezal de lectura/escritura que flota sobre una delgada lámina de aire generada por la rotación de los discos.

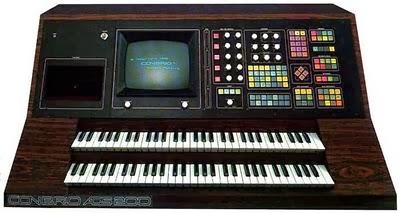

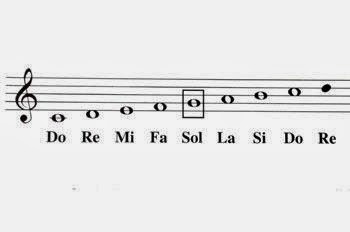

- Teclado: Es un dispositivo de entrada (en parte inspirado en el teclado de las máquinas de escribir,) que utiliza una disposición de botones o teclas, para que actúen como interruptores electrónicos que envían información a la computadora.

- Ratón: Es un dispositivo apuntador utilizado para facilitar el manejo de un entorno gráfico de un ordenador. Detecta su movimiento relativo en dos dimensiones por la superficie plana en la que se apoya, reflejándose habitualmente a través de un puntero o flecha en el monitor.

El software en cambio incluye desde programas como el

procesador de texto al sistema operativo, que básicamente permite al resto de los programas funcionar adecuadamente, facilitando también la interacción entre los componentes físicos y el resto de las aplicaciones, y proporcionando una interfaz al usuario.

Futuro de los ordenadores

Una tendencia constante en el desarrollo de los

ordenadores es la microminiaturización, iniciativa que tiende a comprimir más

elementos de circuitos en un espacio de chip cada vez más pequeño, colocar un

mayor número de transistores en un menor espacio. Llegará un momento en que no

se podrán hacer los chips más pequeños, y esto plantea otros tipos de

ordenadores que están mencionados más adelante en este trabajo. Además, los

investigadores intentan mejorar y aumentar la rapidez del funcionamiento de los

circuitos mediante el uso de la superconductividad, un fenómeno de

disminución de la resistencia eléctrica que se observa cuando se enfrían los

objetos a temperaturas muy bajas.

Las redes informáticas se han vuelto cada vez más

importantes en el desarrollo de la tecnología de computadoras. Como hemos visto

las redes son grupos de computadoras interconectados mediante sistemas de comunicación.

La red pública Internet es un ejemplo de red informática planetaria.

Las redes permiten que las computadoras conectadas intercambien rápidamente

información y, en algunos casos, compartan una carga de trabajo, con lo que

muchas computadoras pueden cooperar en la realización de una tarea. Debido a

esto la evolución de Internet está tan ligada a los ordenadores. Suele

considerarse Internet como la última mayor revolución de la información, pero

no se puede dejar de lado la importancia que tuvo en ella los ordenadores.

Otra tendencia en el desarrollo de computadoras es el

esfuerzo para crear computadoras de quinta generación, capaces de resolver

problemas complejos en formas que pudieran llegar a considerarse creativas. Una

vía que se está explorando activamente es el ordenador de proceso paralelo, que

emplea muchos chips para realizar varias tareas diferentes al mismo tiempo. El

proceso paralelo podría llegar a reproducir hasta cierto punto las complejas

funciones de realimentación, aproximación y evaluación que caracterizan al

pensamiento humano. Es decir, que parece ser que los ordenadores avanzan de

manera tan rápida que no es inconcebible que en un futuro incluso el

pensamiento humano, que crea estas máquinas, se quede por detrás de ellas.

Otra forma de proceso paralelo que se está

investigando es el uso de computadoras moleculares (mediante la

"nanotecnología"). En estas computadoras, los símbolos lógicos se expresan

por unidades químicas de ADN en vez de por el flujo de electrones habitual en

las computadoras corrientes. Las computadoras moleculares podrían llegar a

resolver problemas complicados mucho más rápidamente que las actuales

supercomputadoras y consumir mucha menos energía. Los circuitos moleculares no

son excesivamente rápidos, pero son increíblemente más pequeños. Las familias

de moléculas que parecen más prometedoras para estos ordenadores son las

derivadas de los hidrocarburos aromáticos (específicamente el benceno) y los

nanotubos de carbono (también llamados fulerenos o buckytubes).

Ordenadores cuánticos:

Como está escrito antes, no podemos hacer los chips infinitamente pequeños. Hay un límite a partir del cual dejan de funcionar correctamente. Cuando se llega a la escala de nanómetros, los electrones se escapan de los canales por donde deben circulas. A esto se le llama efecto túnel. Los electrones al comportarse como ondas puede que una parte de ellos pueda atravesar las paredes si son demasiado finas; de esta manera la señal puede pasar por los canales donde no debería circular. Por ello, el chip deja de funcionar correctamente.

En consecuencia, la computación digital tradicional no tardará en llegar a su límite, puesto que ya se ha llegado a escalas de sólo algunas decenas de nanómetros. Surge entonces la necesidad de descubrir nuevas tecnologías y es ahí donde entra la computación cuántica en escena. La idea de computación cuántica surge en 1981, cuando Paul Benniof expuso su teoría para aprovechar las leyes cuánticas en el entorno de la computación. En vez de trabajar a nivel de voltajes eléctricos, se trabaja a nivel de cuanto. En la computación digital, un bit sólo puede tomar dos valores: 0 ó 1. En cambio, en la computación cuántica, intervienen las leyes de la mecánica cuántica, y la partícula puede estar en superposición coherente: puede ser 0, 1 y puede ser 0 y 1 a la vez. Eso permite que se puedan realizar varas operaciones a la vez, según el número de qubits.

Para hacerse una idea del gran avance, un computador cuántico de 30 qubits equivaldría a un procesador convencional de 10 teraflops (10 millones de milloes de operaciones en coma flotante por segundo), cuando actualmente las computadoras trabajan en el orden de gigaflops (miles de millones de operaciones).

Los ordenadores cuánticos presentan algunas dificultades y limitaciones en la actualidad, pero sus posibles aplicaciones, además de las relacionadas con el cálculo, son muy interesantes. Podrían servir para hacer transmisiones absolutamente seguras. Estas transmisiones no implican una seguridad absoluta; el que una transmisión no se pueda interceptar no quiere decir que el ordenador donde se guarde el mensaje ya recibido no pueda ser robado.

Estos ordenadores también se podrán usar para hacer una cosa llamada teleportación, que consiste en leer el estado cuántico de un átomo y copiarlo en otro átomo situado a una gran distancia. Además los ordenadores cuánticos podría llegar a comprobar la veracidad de diferentes teoremas matemáticos, pero su explicación sería tan larga que habría que creerse lo que diría sin poder ver la prueba, la demostración.

Para más información dejo el siguiente link, un artículo curioso en el cual se explica de una forma muy clara y precisa el funcionamiento de los ordenadores cuánticos. Se trata de un artículo muy interesante, e incluso habla para relacionar las tres posiciones que pueden adoptar los bits (0, 1 y ambas la vez) del experimento del gato de Schrödinger. Recomiendo leer (aparte de la explicación de este tipo de ordenador) el apartado de “otras aplicaciones”:

Como está escrito antes, no podemos hacer los chips infinitamente pequeños. Hay un límite a partir del cual dejan de funcionar correctamente. Cuando se llega a la escala de nanómetros, los electrones se escapan de los canales por donde deben circulas. A esto se le llama efecto túnel. Los electrones al comportarse como ondas puede que una parte de ellos pueda atravesar las paredes si son demasiado finas; de esta manera la señal puede pasar por los canales donde no debería circular. Por ello, el chip deja de funcionar correctamente.

En consecuencia, la computación digital tradicional no tardará en llegar a su límite, puesto que ya se ha llegado a escalas de sólo algunas decenas de nanómetros. Surge entonces la necesidad de descubrir nuevas tecnologías y es ahí donde entra la computación cuántica en escena. La idea de computación cuántica surge en 1981, cuando Paul Benniof expuso su teoría para aprovechar las leyes cuánticas en el entorno de la computación. En vez de trabajar a nivel de voltajes eléctricos, se trabaja a nivel de cuanto. En la computación digital, un bit sólo puede tomar dos valores: 0 ó 1. En cambio, en la computación cuántica, intervienen las leyes de la mecánica cuántica, y la partícula puede estar en superposición coherente: puede ser 0, 1 y puede ser 0 y 1 a la vez. Eso permite que se puedan realizar varas operaciones a la vez, según el número de qubits.

Para hacerse una idea del gran avance, un computador cuántico de 30 qubits equivaldría a un procesador convencional de 10 teraflops (10 millones de milloes de operaciones en coma flotante por segundo), cuando actualmente las computadoras trabajan en el orden de gigaflops (miles de millones de operaciones).

Los ordenadores cuánticos presentan algunas dificultades y limitaciones en la actualidad, pero sus posibles aplicaciones, además de las relacionadas con el cálculo, son muy interesantes. Podrían servir para hacer transmisiones absolutamente seguras. Estas transmisiones no implican una seguridad absoluta; el que una transmisión no se pueda interceptar no quiere decir que el ordenador donde se guarde el mensaje ya recibido no pueda ser robado.

Estos ordenadores también se podrán usar para hacer una cosa llamada teleportación, que consiste en leer el estado cuántico de un átomo y copiarlo en otro átomo situado a una gran distancia. Además los ordenadores cuánticos podría llegar a comprobar la veracidad de diferentes teoremas matemáticos, pero su explicación sería tan larga que habría que creerse lo que diría sin poder ver la prueba, la demostración.

Para más información dejo el siguiente link, un artículo curioso en el cual se explica de una forma muy clara y precisa el funcionamiento de los ordenadores cuánticos. Se trata de un artículo muy interesante, e incluso habla para relacionar las tres posiciones que pueden adoptar los bits (0, 1 y ambas la vez) del experimento del gato de Schrödinger. Recomiendo leer (aparte de la explicación de este tipo de ordenador) el apartado de “otras aplicaciones”:

Fuentes: Wikipedia, Todo sobre el Ordenador, Historia

de los ordenadores, colossus -Nombre de la maquina, Ecured, http://www.maderkraft.com/ordenadores_moleculares.pdf , http://www.babab.com/no12/ordenadores.htm